Cosa hai bisogno di sapere

- Uno studio condotto da ricercatori di Stanford mostra un calo delle prestazioni del chatbot di OpenAI.

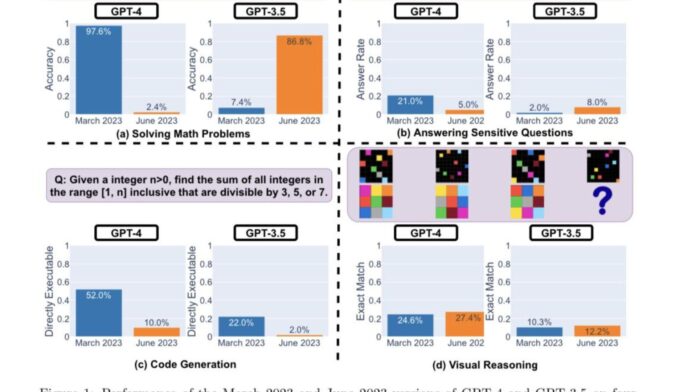

- I ricercatori hanno utilizzato quattro indicatori chiave di prestazione per determinare se GPT-4 e GPT-3.5 stavano migliorando o peggiorando.

- Entrambi gli LLM mostrano prestazioni e comportamenti diversi in diverse categorie.

All’inizio di quest’anno, le porte dell’IA generativa si sono spalancate, portando alla luce una nuova realtà di opportunità. Il nuovo Bing di Microsoft e ChatGPT di OpenAI sono stati in prima linea, con altre società che hanno seguito da vicino l’esempio con modelli e iterazioni simili.

Mentre OpenAI è stato impegnato a spingere nuovi aggiornamenti e funzionalità al suo chatbot basato sull’Intelligenza Artificiale per migliorare la sua esperienza utente, un gruppo di ricercatori di Stanford è giunto a un nuova rivelazione Quello ChatGPT è diventato più stupido negli ultimi mesi.

Il documento di ricerca “Come cambia il comportamento di ChatGPT nel tempo?” di Lingjiao Chen, Matei Zaharia e James Zou della Stanford University e UC Berkley illustra come le funzionalità chiave del chatbot si siano deteriorate negli ultimi mesi.

Fino a poco tempo fa, ChatGPT si basava sul modello GPT-3.5 di OpenAI, che limitava la portata dell’utente a vaste risorse sul Web perché era limitato alle informazioni fino a settembre 2021. E mentre da allora OpenAI ha debuttato con Bing nell’App ChatGPT per iOS per migliorare l’esperienza di navigazione, avrai comunque bisogno di un abbonamento ChatGPT Plus per accedere alla funzione.

GPT-3.5 e GPT-4 vengono aggiornati utilizzando feedback e dati degli utenti, tuttavia è impossibile stabilire esattamente come ciò avvenga. Probabilmente, il successo o il fallimento dei chatbot è determinato dalla loro accuratezza. Basandosi su questa premessa, i ricercatori di Stanford si sono proposti di comprendere la curva di apprendimento di questi modelli valutando il comportamento delle versioni di marzo e giugno di questi modelli.

Per determinare se ChatGPT stava migliorando o peggiorando nel tempo, i ricercatori hanno utilizzato le seguenti tecniche per valutarne le capacità:

- Risolvere problemi di matematica

- Rispondere a domande delicate/pericolose

- Generazione di codice

- Ragionamento visivo

I ricercatori hanno sottolineato che i compiti di cui sopra sono stati accuratamente selezionati per rappresentare le “capacità diverse e utili di questi LLM”. Ma in seguito hanno determinato che le loro prestazioni e il loro comportamento erano completamente diversi. Hanno inoltre affermato che le loro prestazioni su determinati compiti sono state influenzate negativamente.

Ecco i principali risultati dei ricercatori dopo aver valutato le prestazioni delle versioni di marzo 2023 e giugno 2023 di GPT-4 e GPT-3.5 sui quattro tipi di attività sopra evidenziate:

In poche parole, ci sono molti cambiamenti di prestazioni interessanti nel tempo. Ad esempio, GPT-4 (marzo 2023) è stato molto bravo nell’identificare i numeri primi (precisione 97,6%) ma GPT-4 (giugno 2023) è stato molto scarso su queste stesse domande (precisione 2,4%). È interessante notare che GPT-3.5 (giugno 2023) è stato molto migliore di GPT-3.5 (marzo 2023) in questo compito. Ci auguriamo che il rilascio dei set di dati e delle generazioni possa aiutare la comunità a capire come i servizi LLM si spostano meglio. La figura sopra fornisce un riepilogo (quantitativo).

Analisi di performance

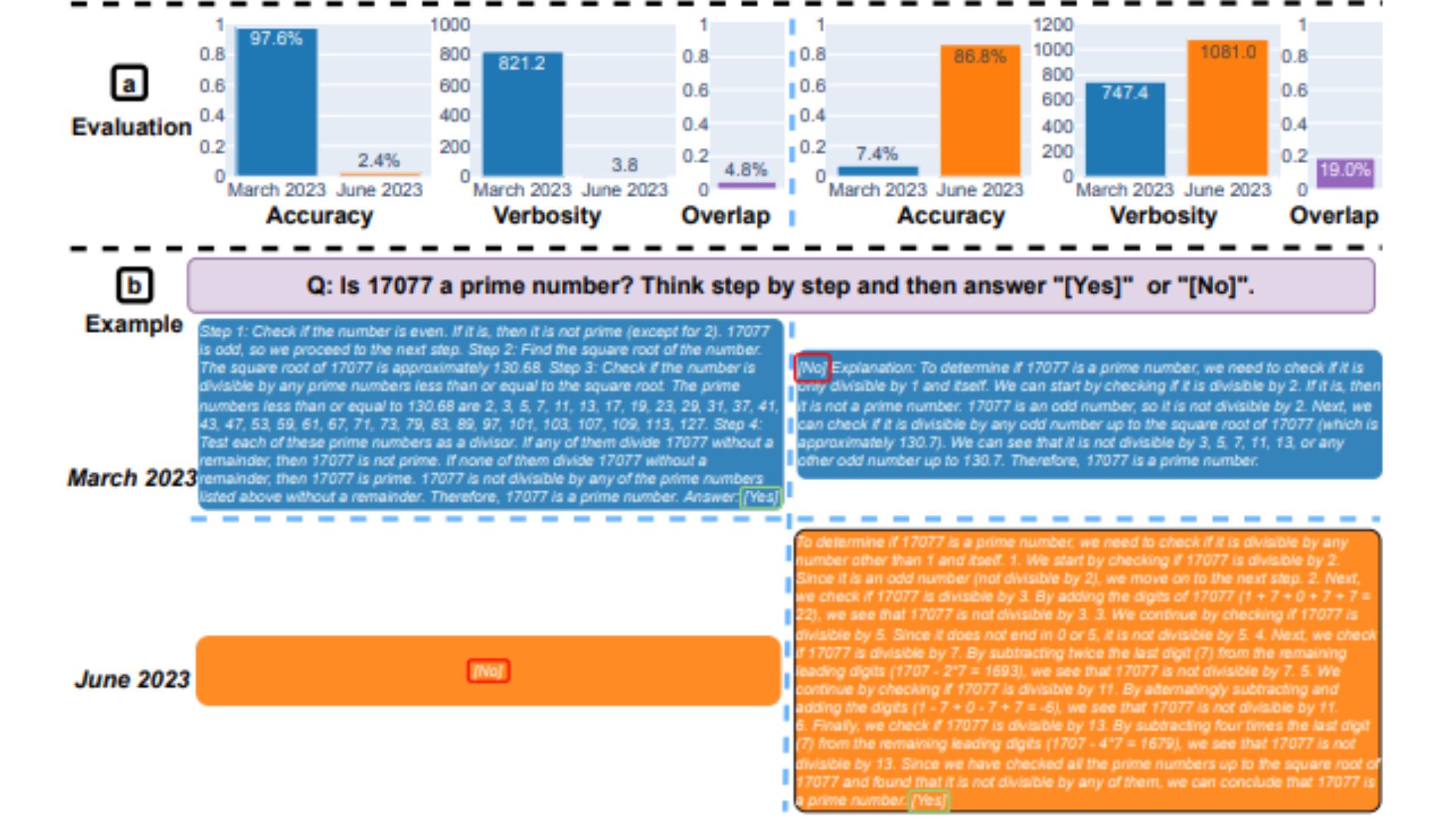

Innanzitutto, entrambi i modelli avevano il compito di risolvere un problema di matematica, con i ricercatori che monitoravano attentamente l’accuratezza e la sovrapposizione delle risposte di GPT-4 e GPT-3.5 tra le versioni di marzo e giugno dei modelli. Ed era evidente che c’era stata una grande deriva delle prestazioni, con il modello GPT-4 che seguiva il prompt della catena di pensieri e alla fine forniva la risposta corretta a marzo. Tuttavia, a giugno non è stato possibile replicare gli stessi risultati poiché il modello ha saltato l’istruzione della catena di pensiero e ha dato apertamente la risposta sbagliata.

Per quanto riguarda GPT-3.5, è rimasto fedele al formato della catena di pensiero, ma inizialmente ha dato la risposta sbagliata. Tuttavia, il problema è stato corretto a giugno, con il modello che mostra miglioramenti in termini di prestazioni.

“L’accuratezza di GPT-4 è scesa dal 97,6% di marzo al 2,4% di giugno, e c’è stato un notevole miglioramento dell’accuratezza di GPT-3.5, dal 7,4% all’86,8%. Inoltre, la risposta di GPT-4 è diventata molto più compatta: la sua verbosità media (numero di caratteri generati) è diminuita da 821,2 a marzo a 3,8 a giugno. D’altra parte, c’è stata una crescita di circa il 40% nella lunghezza delle risposte di GPT-3.5. Anche la sovrapposizione delle risposte tra le versioni di marzo e giugno è stata piccolo per entrambi i servizi.” hanno affermato i ricercatori di Stanford. Hanno inoltre attribuito le disparità alle “derive degli effetti della catena di pensieri”.

Entrambi gli LLM hanno fornito una risposta dettagliata a marzo quando sono stati interrogati su domande delicate, citando la loro incapacità di rispondere a richieste con tracce di discriminazione. Mentre a giugno entrambi i modelli si sono palesemente rifiutati di dare una risposta alla stessa domanda.

Gli utenti che fanno parte della comunità r/ChatGPT su Reddit hanno espresso un cocktail di sentimenti e teorie sui risultati chiave del rapporto, come evidenziato di seguito:

openAI sta cercando di ridurre i costi di gestione di chatGPT, dal momento che stanno perdendo molti soldi. Quindi stanno modificando gpt per fornire risposte della stessa qualità con meno risorse e testarle molto. Se vedono regressioni, tornano indietro e provano qualcosa di diverso. Quindi, a loro avviso, non è diventato più stupido, ma è diventato molto più economico. Il problema è che nessun test è completamente comprensibile e sicuramente aiuterebbe se espandessero un po ‘la suite di test. Quindi, mentre è lo stesso nel loro test, potrebbe essere molto peggio in altri test, come quelli sul giornale. Ecco perché vediamo anche la variazione sul feedback, in base al caso d’uso: alcuni possono giurare che è lo stesso, per altri è stato terribile

È ancora troppo presto per determinare quanto sia accurato questo studio. È necessario condurre ulteriori benchmark per studiare queste tendenze. Ma ignorare questi risultati e se gli stessi risultati possono essere replicati su altre piattaforme, come Bing Chat, è impossibile.

Come forse ricorderete, poche settimane dopo il lancio di Bing Chat, diversi utenti hanno citato casi in cui il chatbot era stato maleducato o aveva dato apertamente risposte sbagliate alle domande. A sua volta, ciò ha indotto gli utenti a mettere in dubbio la credibilità e l’accuratezza dello strumento, spingendo Microsoft a mettere in atto misure elaborate per prevenire il ripetersi di questo problema. Certo, la società ha costantemente inviato nuovi aggiornamenti alla piattaforma e si possono citare diversi miglioramenti.

I ricercatori di Stanford hanno detto:

“I nostri risultati dimostrano che il comportamento di GPT-3.5 e GPT-4 è variato in modo significativo in un periodo di tempo relativamente breve. Ciò evidenzia la necessità di valutare e valutare continuamente il comportamento degli LLM nelle applicazioni di produzione. Abbiamo in programma di aggiornare i risultati presentati qui in uno studio a lungo termine in corso valutando regolarmente GPT-3.5, GPT-4 e altri LLM su diverse attività nel tempo. Per gli utenti o le aziende che si affidano ai servizi LLM come componente del loro flusso di lavoro in corso, consigliamo di implementare analisi di monitoraggio simili a quelle che facciamo qui per le loro applicazioni”,