“Accessibilità” è la parola magica , è la guida verso cui si sta dirigendo la tecnologia attuale. Tutte le tecnologie devono essere rese accessibili a tutti. E se una persona è sorda e / o muta e può parlare solo usando il linguaggio dei segni, dovrebbe essere in grado di svolgere il proprio ruolo in una videochiamata di gruppo proprio come gli altri partecipanti. In questo campo Google sta lavorando con una tecnologia in grado di fare lo stesso.

Rileva la lingua dei segni in una videochiamata

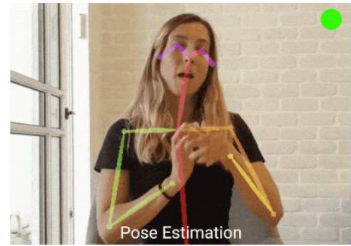

La maggior parte dei servizi di videochiamata utilizza sistemi per evidenziare le persone che parlano ad alta voce nelle riunioni di gruppo, il che è scomodo per le persone con problemi di udito quando comunicano usando il linguaggio dei segni. Per risolvere questo problema, un team di ricercatori di Google Research ha sviluppato un modello di rilevamento della lingua dei segni in tempo reale basato sulla stima delle pose in grado di identificare le persone come parlanti durante la comunicazione con questa lingua.

Il sistema sviluppato da Google, presentato all’evento SLTRP2020 e attraverso una demo alla conferenza europea sulla visione artificiale ECCV’20, utilizza un design leggero che riduce la quantità di carico della CPU necessaria per eseguirlo, e quindi non influisce la qualità delle chiamate.

Secondo Google, per abilitare una soluzione di lavoro in tempo reale per una varietà di applicazioni di videoconferenza, ” avevamo bisogno di progettare un modello leggero che fosse semplice da” plug and play “. Poiché il linguaggio dei segni coinvolge il corpo e le mani dell’utente, abbiamo iniziato eseguendo un modello di stima della posa, PoseNet. Ciò riduce notevolmente l’input di un’immagine Full HD a un piccolo insieme di punti di riferimento sul corpo dell’utente, inclusi occhi, naso, spalle, mani, ecc. ”.

La tecnologia utilizza questi punti di riferimento per calcolare il flusso ottico fotogramma per fotogramma, che quantifica il movimento dell’utente che deve essere utilizzato dal modello senza conservare le informazioni specifiche dell’utente. Ogni posa è normalizzata dalla larghezza delle spalle della persona per garantire che il modello si rivolga alla persona che firma a una distanza dalla telecamera. Il flusso ottico viene quindi normalizzato dal frame rate del video prima di passare al modello.

83% di efficienza

Per testare questo approccio, “abbiamo utilizzato il corpus della lingua dei segni tedesca (DGS), che contiene lunghi video di persone che firmano e include annotazioni in time-lapse che indicano in quali frame vengono realizzati i segni “. Hanno quindi addestrato un modello di regressione lineare per prevedere quando una persona sta firmando utilizzando i dati del flusso ottico. Questa linea di base ha raggiunto una precisione di circa l’80%, utilizzando solo ~ 3μs (0,000003 secondi) di tempo di elaborazione per frame. Includendo il flusso ottico dei precedenti 50 fotogrammi come contesto per il modello lineare, è in grado di raggiungere l’83,4%.

Per generalizzare l’uso del contesto, “usiamo un’architettura di memoria a lungo e breve termine (LSTM), che contiene la memoria sui passaggi temporali precedenti, ma senza guardare indietro “. Utilizzando un LSTM a livello singolo, seguito da uno strato lineare, il modello raggiunge una precisione fino al 91,5%, con 3,5 ms (0,0035 secondi) di tempo di elaborazione per fotogramma.

Verifica teorica

Dopo aver ottenuto un modello di rilevamento della lingua dei segni funzionante, gli esperti di Google hanno sviluppato una demo web leggera e in tempo reale per il rilevamento della lingua dei segni che si collega a varie applicazioni di videoconferenza e può impostare l’utente come ” speaker “durante la firma. Questa demo sfrutta i modelli di stima rapida della postura umana e rilevamento del linguaggio dei segni di PoseNet che vengono eseguiti nel browser utilizzando tf.js, consentendo di lavorare in modo affidabile in tempo reale.

Quando il modello di rilevamento della lingua dei segni determina che un utente sta accedendo a una videochiamata, trasmette un tono audio ultrasonico attraverso un cavo audio virtuale, che può essere rilevato da qualsiasi applicazione di videoconferenza come se l’utente che firma stava ” parlando “. L’audio viene trasmesso a 20 kHz, che normalmente è al di fuori del raggio uditivo delle persone.

Una tecnologia open source

Poiché le applicazioni di videoconferenza tendono a rilevare il “volume” dell’audio come se stesse parlando piuttosto che rilevare unicamente il parlato , questa tecnologia riesce a ingannare l’applicazione facendole credere che l’utente che utilizza il linguaggio dei segni stia parlando come se stesse usando la sua voce .

I ricercatori hanno pubblicato il loro modello di rilevamento open source sulla piattaforma GitHub e sperano che la loro tecnologia possa essere ” sfruttata per consentire ai parlanti della lingua dei segni di utilizzare le videoconferenze in modo più conveniente”.